Journal of Ambient Intelligence and Humanized Computing Pub Date : 2022-05-23 , DOI: 10.1007/s12652-022-03874-1

Yaming Wang , Xiaoyan Jiang , Hamido Fujita , Zhijun Fang , Xihe Qiu , Jue Chen

|

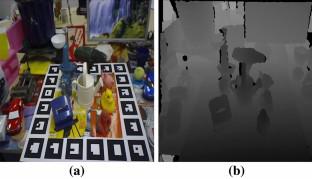

精确的 6DoF (6D) 物体姿态估计是许多智能应用的基本主题,例如机器人抓取、虚拟现实和自动驾驶。由于缺乏深度信息,仅使用 RGB 相机的传统姿势估计器始终可以预测偏置 3D 旋转和平移矩阵。随着 RGB-D 相机的广泛使用,我们可以直接捕捉物体相对于相机的深度和相应的 RGB 图像。现有的方法大多是直接将这两个数据源串联起来,没有充分利用它们的互补关系。因此,我们提出了一种用于 6D 姿态估计的高效 RGB-D 融合网络,称为 EFN6D,以更彻底地利用 2D-3D 特征。而不是直接使用原始的单通道深度图,我们将深度信息编码为法线贴图和点云数据。为了有效地融合物体的表面纹理特征和几何轮廓特征,我们将 RGB 图像和法线图输入到两个 ResNet 中。此外,两个 ResNet 之间使用了 PSP 模块和跳跃连接,不仅增强了网络的跨模态融合性能,而且增强了网络处理不同尺度对象的能力。最后,将这两个 ResNet 得到的融合特征与点云特征逐点密集融合,进一步加强了 2D 和 3D 信息在逐像素级别的融合。LINEMOD 和 YCB-Video 数据集的实验表明,我们的 EFN6D 大大优于最先进的方法。为了有效地融合物体的表面纹理特征和几何轮廓特征,我们将 RGB 图像和法线图输入到两个 ResNet 中。此外,两个 ResNet 之间使用了 PSP 模块和跳跃连接,不仅增强了网络的跨模态融合性能,而且增强了网络处理不同尺度对象的能力。最后,将这两个 ResNet 得到的融合特征与点云特征逐点密集融合,进一步加强了 2D 和 3D 信息在逐像素级别的融合。LINEMOD 和 YCB-Video 数据集的实验表明,我们的 EFN6D 大大优于最先进的方法。为了有效地融合物体的表面纹理特征和几何轮廓特征,我们将 RGB 图像和法线图输入到两个 ResNet 中。此外,两个 ResNet 之间使用了 PSP 模块和跳跃连接,不仅增强了网络的跨模态融合性能,而且增强了网络处理不同尺度对象的能力。最后,将这两个 ResNet 得到的融合特征与点云特征逐点密集融合,进一步加强了 2D 和 3D 信息在逐像素级别的融合。LINEMOD 和 YCB-Video 数据集的实验表明,我们的 EFN6D 大大优于最先进的方法。两个 ResNet 之间使用了 PSP 模块和跳跃连接,不仅增强了网络的跨模态融合性能,而且增强了网络处理不同尺度对象的能力。最后,将这两个 ResNet 得到的融合特征与点云特征逐点密集融合,进一步加强了 2D 和 3D 信息在逐像素级别的融合。LINEMOD 和 YCB-Video 数据集的实验表明,我们的 EFN6D 大大优于最先进的方法。两个 ResNet 之间使用了 PSP 模块和跳跃连接,不仅增强了网络的跨模态融合性能,而且增强了网络处理不同尺度对象的能力。最后,将这两个 ResNet 得到的融合特征与点云特征逐点密集融合,进一步加强了 2D 和 3D 信息在逐像素级别的融合。LINEMOD 和 YCB-Video 数据集的实验表明,我们的 EFN6D 大大优于最先进的方法。将这两个 ResNet 得到的融合特征和点云特征逐点密集融合,进一步加强了 2D 和 3D 信息在逐像素级别的融合。LINEMOD 和 YCB-Video 数据集的实验表明,我们的 EFN6D 大大优于最先进的方法。将这两个 ResNet 得到的融合特征和点云特征逐点密集融合,进一步加强了 2D 和 3D 信息在逐像素级别的融合。LINEMOD 和 YCB-Video 数据集的实验表明,我们的 EFN6D 大大优于最先进的方法。

"点击查看英文标题和摘要"

京公网安备 11010802027423号

京公网安备 11010802027423号